Die Hamburger Polizei experimentiert am Hansaplatz mit KI, genauer mit Verhaltenserkennung. KI soll unerwünschtes Verhalten erkennen und die Polizei benachrichtigen. Die Polizei darf ihren Versuch selbst evaluieren, also wurden selbstverständlich alle Ziele erreicht. Zum Glück heißt es im Koalitionsvertrag von SPD und Grüne im Abschnitt Digitalisierung und gesellschaftliche Verantwortung:

Wir werden beim Einsatz von KI-Anwendungen in Hamburger Behörden sicherstellen, dass grundsätzlich Transparenz, Nachvollziehbarkeit und Überprüfbarkeit gegeben sind. Wo es fachlich vertretbar ist, sollen von bzw. für die Hamburger Verwaltung entwickelte Algorithmen öffentlich verfügbar gemacht werden. KI-Trainingsdaten sollen in der Kontrolle der Behörden verbleiben, soweit diese nicht im Rahmen eines Datenaustausches in größere Datenpools eingebracht werden. Zudem wollen wir einen behördenübergreifenden Standard zur Überprüfung der Diskriminierungsfreiheit bei KI und Algorithmen einführen, damit die Souveränität über die Verfahren bewahrt wird.

Wir können also Transparenz erwarten, vielleicht sogar einen Blick in die Trainingsdaten werfen und damit nachvollziehen und überprüfen, ob der Versuch tatsächlich so erfolgreich war wie behauptet.

Leider wurde meine Transparenzanfrage zu dem Projekt über ein Jahr lang nicht beantwortet. Und auch dann wurde nur ein kleiner Teil der angefragten Dokumente zur Verfügung gestellt. In diese Dokumente, Evaluations- und Projektabschlussbericht, schauen wir nun einmal rein.

Ausgangslage

Seit geraumer Zeit gibt es auf dem Hansaplatz Kameras. Schon 2019 wurde festgestellt, dass diese Kameras gar keine sozialen Probleme lösen, sondern nur verlagern. Das Problem sei der Alkohol, ganze Völkerschaften kämen, um hier ungezügeltem Konsum nachzugehen, meint der ehemalige Bezirksamtsleiter und Anwohner des Hansaplatzes, Markus Schreiber. Also wird versucht, das Problem mit noch mehr Technik zu erschlagen.

Passenderweise arbeitet das Fraunhofer IOSB an einer Überwachungstechnologie, die mehr Sicherheit und mehr Datenschutz bieten soll! Das Institut betreibt in Mannheim ein “Pilotprojekt”, das nach fünf Jahren Laufzeit so “erfolgreich” war, dass die Pilotphase um drei Jahre verlängert wurde.

Dies hat die Stadt Hamburg überzeugt, man möchte das System auch hier testen.

Evaluation

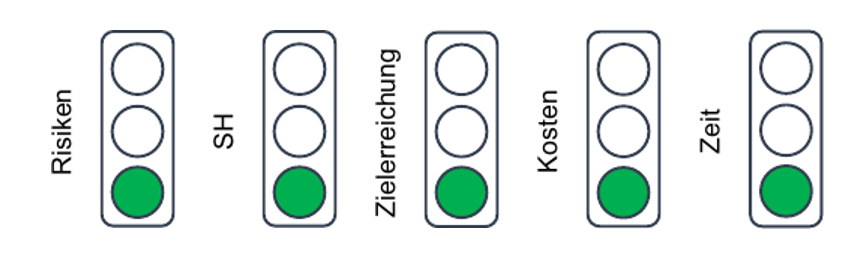

Da es sich bewährt hat, dass sich die Polizei selbst evaluiert, verzichtete man auch in Hamburg auf eine wissenschaftliche Begleitung und Evaluation des Pilotprojekts. Auf zusätzliches Personalressourcen zur Auswertung der Ergebnisse wurde verzichtet. Drei Ziele wurden definiert:

- Evaluationsoberziel war die Erkenntnisgewinnung über eine Skalierbarkeit der im Rahmen des Sicherheitskonzeptes “Mannheimer Weg 2.0” bereits antrainierten Deep-Learning-Modelle in die Videomanagementinfrastruktur der Polizei Hamburg. Aha.

- Dokumentation der Testergebnisse

- Schaffung von Transparenz

Evaluationsoberziel

Ich deute das Evaluationsoberziel so, dass herausgefunden werden soll, ob das System in die Video-Infrastruktur der Polizei Hamburg integriert werden kann. Dazu heißt es im Evaluationsbericht: Die Erstintegration der Hardware und DL-Modelle erfolgte in gemeinsamer Arbeit durch die IT und das IOSB. Die Dauer betrug 5 Arbeitstage. Zu Beginn der eigentlichen Testphase folgte die Parametrierung der DL-Modelle, um die Detektionsqualität für die Evaluierungsphase bestmöglich einzustellen. Diese Phase betrug weitere 9 Arbeitstage.

Es ist offenbar gelungen, die Fraunhofer-Software an das bestehende System ranzudengeln.

Dokumentation der Testergebnisse

Zweites Ziel des Versuchs ist nicht etwa herauszufinden und zu bewerten, ob und wie gut der Kram funktioniert. Stattdessen sollen die Testergebnisse dokumentiert werden. Die Polizei war bemüht, dieses Ziel zu erreichen. Es fehlen allerdings wichtige Informationen, ohne die eine Bewertung des Projekts nicht erfolgen kann. Nicht angegeben werden etwa

- Anzahl der falsch-positiven Erkennungen oder der falsch-negativen Erkennungen,

- eine Definition des zu erkennenden strafbaren Verhaltens oder Kriterien zur Erkennung strafbaren Verhaltens,

- Versionnummern der getesteten Software und des KI-Modell,

- Parametrierung der DL-Modelle,

- Details zu Fehlalarmen,

- Details zur eingesetzten Technik, einschließlich der Kameras,

- Informationen über die konkreten von den Kameras erfassten Räume.

Die Polizei ist bei der Dokumentation der Testergebnisse also grandios gescheitert. Dennoch versuchen wir uns an der Interpretation des übrigen Evaluationsberichts.

Systemausfall

Das System fiel aufgrund sich aufhängender Bildströme zweimal aus. Die Hinweisgenerierung an die “Videobeobachter” fiel für mehrere Tage aus. Der Ausfall wurde erst retrograd bemerkt. Genaue Zeitpunkte und Dauer der Ausfälle konnten technisch nicht nachvollzogen werden.

Die eigentliche Detektion soll hiervon nicht betroffen gewesen sein (Magie? KI?).

Detektionsqualität

Die Anzahl der Detektionen und entsprechende Hinweisgenerierungen betrug etwa eine pro Stunde. Bei einem Evaluationszeitraum von 59 Tagen (21.07.2023 bis 17.09.2023), also 1416 Stunden, wurden folglich ungefähr 1416 Hinweise generiert. In diesem Zeitraum wurden 11 Hinweise generiert, die als polizeilich relevant eingestuft werden. Damit werden mehr als 99% der Hinweise, die das Fraunhofer-System generiert, als polizeilich nicht relevant eingestuft. Dieser Hinweis fehlt im Evaluationsbericht.

Ein zusätzlicher 12. polizeilich relevanter Sachverhalt wurde im Rahmen der klassischen Videoüberwachung erkannt. Daraus leitet die Polizei absurderweise ab, dass 92% polizeilich relevanter Gefahrensituationen erkannt wurden. Die Möglichkeit, einen polizeilich relevanten Sachverhalt gar nicht erst bemerkt zu haben, fällt unter den Tisch.

Die ca. 1405 falschen Hinweise wurden nur stichprobenartig ausgewertet. Eine technische Übermittlung der Posenschätzung, die zu einem Hinweis führte (bspw. liegende Körperhaltung), erfolgte nicht. Die Bewertung der Stichproben erfolgte viel mehr “augenscheinlich”. Eindeutig falsche Detektionen sollen dabei nicht bemerkt worden sein. Die Anzahl der Stichproben und welche Posen als richtige Detektion bewertet wurden, sind nicht bekannt.

Interventionsbeschleunigung

Es soll beurteilt werden, ob die Polizei dank KI-Hinweisen schneller intervenieren kann als bei einem klassischen Notruf, der über die Polizeieinsatzzentrale eingeht.

Statistisch auswertbare Ergebnisse zur Interventionsbeschleunigung wurden im Rahmen des Projekts nicht gesammelt. Die Polizei kommt dennoch zu dem Schluss, dass der KI-Hinweis immer einen geringeren zeitlichen Verzug mit sich bringt.

Ressourcen

Ein Mehrwert des Projekts soll Ressourcenfreisetzung durch KI sein. Angaben zur Personalstärke macht die Polizei aber aus grundsätzlichen Erwägungen nicht. Insofern kann nicht beurteilt werden, ob das System Personal einsparen würde.

Schaffung von Transparenz

Im Evaluationsbericht wird Transparenz über die Zielsetzung “Schaffung von Transparenz” hinaus nicht erwähnt. Im Transparenzportal der Stadt sind keine Informationen zu IVBeo zu finden. IFG-Anfragen wurden extrem verzögert und nicht vollständig beantwortet. Die Studie wurde auch nicht im Transparenzportal der Stadt veröffentlicht. Der auf Nachfrage preisgegebene Evaluationsbericht hat den Namen nicht verdient, zu viele Informationen fehlen. Das Ziel “Schaffung von Transparenz” wurde also verfehlt.

Fazit

Der KI-Versuch der Hamburger Polizei scheitert an gravierenden Mängeln in Planung, Durchführung und Evaluation. Die von der Polizei selbst durchgeführte Evaluation ist weder vollständig noch nachvollziehbar, wichtige Daten wie Fehlerraten oder Details zu eingesetzten Modellen fehlen. Auch das Ziel der Transparenz wurde klar verfehlt: Informationsanfragen blieben unbeantwortet, und der Evaluationsbericht enthält entscheidende Lücken.

Dennoch vermeldet die Polizei Erfolg. Das ist mehr als fragwürdig, basieren die Ergebnisse doch auf selektiver und unvollständiger Datengrundlage. Das System zeigte mehrere Ausfälle. Belastbare Daten für schnellere oder effizientere Polizeieinsätze durch KI fehlen völlig.

Schließlich ignoriert das Projekt den im rot-grünen Koalitionsvertrag angedachten Standard für Transparenz und Nachvollziehbarkeit beim Einsatz von KI. Trotzdem scheint eine Fortführung geplant – wenig überraschend bleibt auch dies intransparent.